I droni pilotati a distanza non bastano. L’industria bellica sta sviluppando armi del tutto autonome. La decisione di uccidere così potrebbe essere delegata. E i pacifisti si mobilitano

I missili Brimstone già distinguono tra tank e macchine e possono inseguire un bersaglio senza supervisione

Dal 2002 a oggi le persone uccise da Uav americani nei campi di battaglia sarebbero circa 4000

Articoli di Gabriele Catania

Forse tra qualche decennio i corrispondenti di guerra (se esisteranno ancora) racconteranno di scontri devastanti tra carri armati automatizzati, o tra sciami di robot volanti. Una Götterdämmerung high-tech degna di un romanzo di Robert Heinlein o Philip Dick che realizzerebbe in pieno la sintesi di Thomas Edison: «La guerra moderna è più una questione di macchine che di uomini».

Questa visione al momento pare davvero uscire da un libro di fantascienza, ma sono già state investite ingenti quantità di denaro per accorciare i tempi che ci separano dai futuri campi di battaglia sui quali, secondo gli esperti, i robot nel XXI secolo potrebbero svolgere un ruolo decisivo. Ipotesi che desta non poca inquietudine e sulla quale la comunità internazionale ancora deve pronunciarsi.

Lo scorso 14 novembre, i Paesi aderenti alla Convenzioni Onu delle armi convenzionali si sono riunite a Ginevra per discutere quelli che tecnicamente vengono definiti sistemi d’arma autonomi letali (Laws) e che i pacifisti hanno già ribattezzato «robot assassini». I convenuti, che avevano avviato i primi colloqui nel maggio del 2014, hanno per ora deciso di non decidere fissando un nuovo appuntamento per il prossimo aprile.

Negli stessi giorni (l’11 novembre) il New York Times ha pubblicato un articolo sul prototipo di un missile anti-nave sviluppato dall’americana Lockheed Martin, capace di scegliersi da solo l’imbarcazione da distruggere, uno tra i tanti robot che secondo lo studioso statunitense Peter W. Singer, autore del saggio Wired for war – the robotics revolution and conflict in the 21st century (Penguin), cambieranno non solo il modo in cui facciamo la guerra, ma anche chi la fa. Il loro impatto assicura sarà più rivoluzionario di quello delle testate nucleari nel XX secolo. «Negli ultimi due anni di versi rapporti e convegni hanno evidenziato l’esistenza di sistemi robotici con diversi gradi di autonomia e letalità. – dice a pagina99 Mary Wareham, responsabile della divisione armamenti dell’ong Human Rights Watch (Hrw). Fa alcuni esempi: i droni aerei Predator e Reaper (Stati Uniti), e quelli terrestri Guardium (Israele); i prototipi di aerei da combattimento senza pilota X-47B (Stati Uniti) e Taranis (Regno Unito), capaci di cercare, identificare e (se autorizzati) ingaggiare i nemici; le sentinelle robotizzate Sgr-A1 (Corea del Sud) e Sentry Tech (Israele), con sensori per individuare gli obiettivi, e mitragliatrici pronte a far fuoco. E i missili britannici Brimstone già distinguono tra tank e macchine e possono inseguire un bersaglio senza aver bisogno di supervisione umana.

Sia chiaro però: al momento nessun esercito del mondo ha in dotazione robot autonomi letali (Lar) in grado di uccidere una persona senza il comando diretto di un altro essere umano. E comunque, «c’è ancora un grande divario tra le decisioni che l’intelligenza artificiale e i sensori possono prendere, e quello che si vede nei film di Hollywood, tuttavia, è un divario destinato a ridursi ogni giorno – è l’opinione personale di Quentin Ladetto, research director della Armasuisse (il centro di competenza elvetico per l’acquisto di sistemi e materiali tecnologici complessi per l’esercito) – Quanto affidabile può essere una macchina, e in quali circostanze può decidere se una persona rappresenta una minaccia o no, e in tal caso rispondere in modo proporzionale? Sono questi gli interrogativi cruciali. E poi conta pure dove viene dispiegato il sistema d’arma. Per esempio, se un Laws è istallato a difesa permanente di una centrale nucleare è una cosa, se invece è mobile e opera in una città con militari ma anche civili è un’altra. Comunque ho l’impressione che in futuro si produrranno sì Laws, ma nell’ambito di società con un alto grado di automazione, dove circoleranno già auto che si guidano da sole, robot e così via».

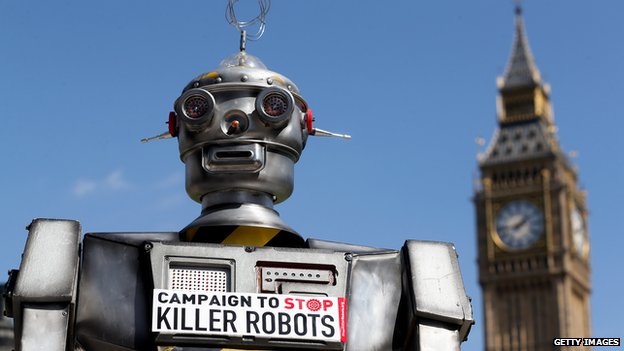

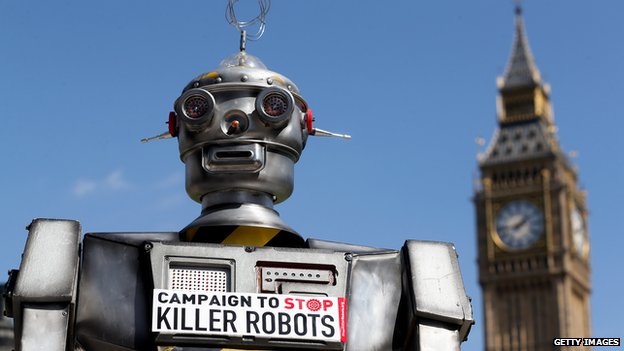

In ogni caso le Ong di tutto il mondo sono sul piede di guerra. In particolare, ha destato l’attenzione dei media la campagna Stop Killer Robots, promossa tra l’altro proprio dalla Hrw. «La campagna vuole proibire in via preventiva e totale lo sviluppo, la produzione e l’uso dei cosiddetti robot assassini. – spiega la Wareham, che è anche coordinatrice della campagna – Il nostro obiettivo è proibire che gli esseri umani siano estromessi dal controllo delle armi autonome». Probabilmente le ong fanno bene ad agire in anticipo.

In ogni caso le Ong di tutto il mondo sono sul piede di guerra. In particolare, ha destato l’attenzione dei media la campagna Stop Killer Robots, promossa tra l’altro proprio dalla Hrw. «La campagna vuole proibire in via preventiva e totale lo sviluppo, la produzione e l’uso dei cosiddetti robot assassini. – spiega la Wareham, che è anche coordinatrice della campagna – Il nostro obiettivo è proibire che gli esseri umani siano estromessi dal controllo delle armi autonome». Probabilmente le ong fanno bene ad agire in anticipo.

In un rapporto del 2012 diretto al presidente Barack Obama, il National Intelligence Council Usa prevede: «Ci si aspetta che i militari utilizzino di più i robot per ridurre l’esposizione umana in situazioni o ambienti ad alto rischio, così come il numero di truppe necessarie per certi tipi di operazioni». Ancora: «I veicoli autonomi potrebbero trasformare le operazioni militari, la risoluzione dei conflitti, il trasporto e il rilevamento geografico. Veicoli aerei privi di equipaggio (Uav, i droni aerei) sono già usati a scopo di spionaggio o per lanciare missili. Entro il 2030, gli Uav potrebbero essere comunemente usati per monitorare i conflitti, far rispettare le no-fly zone, sorvegliare i confini».

Previsioni a parte, è innegabile l’esistenza di un trend globale verso la creazione di sistemi d’arma autonomi tanto sofisticati quanto distruttivi. «I sistemi privi di esseri umani stanno offrendo un contributo significativo alle operazioni del Dipartimento della difesa in tutto il mondo» rileva un lungo rapporto del Defense Science Board del Pentagono, riferendosi principalmente agli Uav. «Credo che i sistemi pilotati a distanza avranno un grande impatto sulle prossime guerre. Lo scopo è porre una distanza tra chi combatte e il teatro di guerra, ed evitare morti, almeno da un lato – spiega Ladetto – Penso invece che le forze armate non siano pronte (quanto a mentalità, procedure, regole di condotta e così via) ad adottare i Laws. Personalmente sarei più preoccupato dell’utilizzo, nei prossimi decenni, di sistemi d’arma a pilotaggio remoto, in grado di generare enormi tensioni e scontri asimmetrici che potrebbero condurre a nuove forme di violenza a causa dell’incapacità delle persone di reagire al nemico».

Secondo dati ufficiali americani, dal 2005 al 2010 le ore volate dagli Uav sono passate da 10 mila a oltre 500 mila. E le persone uccise dal 2002 a oggi sarebbero, secondo una stima dell’American Civil Liberties Union, circa 4000. Da quando Obama è stato eletto alla Casa Bianca, la guerra globale al terrorismo islamista è stata combattuta sempre di più attraverso i voli letali di Uav come il già citato Predator.

Ma per quanto possano essere terrorizzanti (i civili afgani arrivano a paragonare i droni a mostruosi angeli della morte), gli Uav non sono ancora Laws. Chi ordina il lancio di un missile contro un obiettivo nemico è sempre una persona. Che magari si trova a migliaia di chilometri di distanza dal teatro di guerra. Come Brandon Bryant, che dal 2006 al 2011 è stato remotely-piloted-aircraft sensor operator presso la base aeronautica di Nellis, alla periferia di Las Vegas. Il mensile Gq, che lo ha intervistato nell’autunno del 2013, lo ha descritto come “la macchina assassina americana del XXI secolo”; Bryant però non è un robot, ed è ancora ossessionato da quegli anni, quando operava in modalità zombie in missioni che avrebbero provocato la morte di oltre 1600 persone.

La guerra con i droni può ricordare un videogioco: l’operatore combatte comodamente seduto su una poltrona ergonomica, gli occhi puntati sullo schermo, e le dita incollate alla tastiera. Di tanto in tanto può dissetarsi con un sorso di gazzosa, o placare i

morsi della fame sgranocchiando uno snack. Niente sangue, né urla, né fumo: solo numeri, parole e immagini sfocate su un monitor ultrapiatto.

Ma la spersonalizzazione della guerra è solo agli inizi. Lo sottolinea a pagina99 Francesco Vignarca, coordinatore nazionale della Rete Italiana per il Disarmo. «A differenza dei droni, che comunque sono guidati a distanza da esseri umani, i Laws avranno appunto la capacità di decidere in modo autonomo. Non sarà più la persona a schiacciare il famigerato bottone rosso: dalla spersonalizzazione della guerra si passerà così alla sua disumanizzazione».

Jürgen Altmann, ricercatore e docente di fisica all’università tedesca di Dortmund, ̀ tra i membri fondatori del Comitato internazionale per il controllo delle armi robot (Icrac).

Elenca i motivi per proibire i robot assassini. «Per i prossimi decenni, i sistemi informatici o le cosiddette intelligenze artificiali non potranno garantire il rispetto del diritto internazionale umanitario, almeno in situazioni di moderata complessità. Si pensi a principi fondamentali come la distinzione tra i combattenti e i non-combattenti; o a regole specifiche come riconoscere quando un combattente è hors de combat».

Preoccupatissimo è pure Noel Sharkey, docente emerito di intelligenza artificiale e robotica all’università di Sheffield, nel Regno Unito, nonché presidente del comitato internazionale per il controllo delle armi robot (Icrac): «Supereremmo un confine morale cruciale delegando la decisione di uccidere alle macchine. Sarebbe l’inizio di un possibile futuro da incubo. – dichiara a pagina99 – Dare ai robot una simile scelta sarebbe il più grande insulto immaginabile alla dignità umana».

Bandire i nuovi killer prima che siano nati

Il rischio che in un futuro prossimo venturo le grandi potenze del pianeta schierino sistemi d’arma autonomi (Laws) è sempre più concreto. Ma contro i “robot assassini” si è già formato un vasto (ed eterogeneo) fronte di Ong, media indipendenti, intellettuali, attivisti. Punta di diamante di questa mobilitazione internazionale è la campagna Stop Killer Robots. A promuoverla sono alcuni tra i pesi massimi della difesa dei diritti umani, inclusi Pax, la Nobel Women’s Initiative, Human Rights Watch (Hrw).

«La nostra organizzazione e la campagna Stop Killer Robots ha numerosi risvolti di carattere morale, etico, legale, politico, tecnico e militare. – dice a pagina99 la coordinatrice della campagna, Mary Wareham, che è pure a capo della divisione armamenti di Hrw – L’aspetto più significativo riguarda la possibilità di dare alle macchine la possibilità di stroncare delle vite umane sul campo di battaglia, o nel corso di operazioni di polizia o in altre situazioni. Si andrebbe troppo oltre, molti pensano che si supererebbe una linea che non deve essere superata». A parere della Wareham, «il diritto internazionale attuale non è pensato e non può affrontare in modo adeguato le problematiche sollevate dai sistemi d’arma autonomi; peraltro ci sarebbero difficoltà significative ad addebitare a qualcuno la responsabilità per l’uso di queste armi. Che, peraltro, potrebbero abbassare la soglia per l’utilizzo della forza».

Dello stesso parere Francesco Vignarca, coordinatore nazionale della Rete Italiana per il Disarmo (che in Italia rilancia la campagna Stop Killer Robots). «Con i Laws sarà molto più facile fare la guerra, perché si sterilizzerà il discorso pubblico. Scoppia la guerra, si mobilitano le macchine, e dal momento che le uccisioni sono compiute da robot non c’è dibattito, né parlamentare né mediatico». La campagna vuole bandire i Laws ancora prima che essi siano sviluppati; lo spiega bene la Wareham. «Dato il numero di questioni di rilievo che sollevano, i sistemi d’arma autonomi dovrebbero essere proibiti in via preventiva prima che sia troppo tardi. Infatti potrebbe essere difficile bloccare la tecnologia una volta che sono stati fatti degli investimenti massicci a riguardo. La tentazione di utilizzare tecnologia già presente negli arsenali militari sarebbe forte, e un gran numero di nazioni sarebbero riluttanti a rinunciarvi, specie in caso di utilizzo da parte degli avversari». I timori della Wareham sembrano essere fondati.

La campagna Stop Killer Robots è stata lanciata oltre un anno fa e qualche risultato ha contribuito a portarlo. «Alla riunione degli Stati membri della Convenzione sulle Armi Convenzionali (Ccw) del novembre 2013, i governi hanno deciso di inaugurare delle discussioni multilaterali sulle tecnologie emergenti, specie i sistemi d’arma autonomi. – conclude la Wareham – Il primo meeting informale di esperti si è tenuto presso la sede dell’ONU a Ginevra dal 13 al 16 maggio 2014 e ha fornito dei rapporti preliminari sulle politiche dei governi e sulle preoccupazioni che queste armi destano».

In un altro incontro, tenutosi lo scorso novembre sempre a Ginevra, è emersa la preoccupazione a riguardo di nazioni come i Paesi Bassi, la Spagna, l’Irlanda. Qualcosa, a livello governativo, si muove. «Il termine “robot assassino” è pittoresco, ma non aiuta molto a distinguere tra i droni e i sistemi d’arma totalmente autonomi: entrambi sono robot ed entrambi possono uccidere. – spiega a pagina99 Stuart Casey-Maslen, giurista della Geneva Academy of International Humanitarian Law and Human Rights – I droni sono pilotati a distanza da una donna o un uomo seduto su una poltrona con un joystick e un monitor; i sistemi d’arma totalmente autonomi sono capaci di individuare i bersagli e sparare senza la necessità di un intervento umano».

E in effetti le sigle non sono tutte uguali, specialmente quando si parla di tecnologie che hanno importanti ricadute nell’ambito dei diritti umani. I droni sono tutti Uv (Unmanned Vehicle): veicoli privi di equipaggio, sottoposti a controllo umano a distanza, e che non sempre hanno scopi di natura militare. Si dividono in categorie diverse: ci sono gli Unmanned Aerial Vehicle (Uav), droni volanti identificati in lingua italiana con la sigla Apr (Aeromobile a Pilotaggio Remoto), e definiti Unmanned Combat Aerial Vehicle (Ucav) se muniti di un qualche tipo d’arma; gli Unmanned Ground Vehicle (Ugv), droni terrestri senza pilota; gli Unmanned Surface Vehicles (Usv), droni marini, e gli Unmanned Underwater Vehicles (Uuv), droni sottomarini. Si parla di sciami di droni quando ci si riferisce invece a veicoli aerei, terrestri o acquatici (spesso di piccole dimensioni) che operano in modo collettivo, dialogando tra loro come fanno certi insetti o pesci. Quanto ai sistemi d’arma automatici, essi sono definiti in inglese con il nome di Autonomous Weapon Systems (Aws), sistemi d’arma autonomi che possono essere letali (Laws) o no, quando sono dotati di armi “non letali” come dispositivi per il lancio di gas lacrimogeni o pistole con pallottole di gomma.

Con Fully Autonomous Weapon Systems (Faws) ci si riferisce a sistemi d’arma totalmente automatizzati, dove il fattore umano non gioca alcun ruolo (né in-the-loop né on-the-loop, come dicono gli esperti). Un rapporto del Consiglio per i diritti umani dell’Onu del 2013 preferisce invece parlare di Lethal Autonomous Robotics (Lar), cioè sistemi d’arma che, una volta attivati, possono scegliere e ingaggiare obiettivi senza ulteriori interventi umani.

Potenze tecnologiche e militari come gli USA, il Giappone e la Corea del Sud (che sono leader mondiali nel campo della robotica), Israele, il Regno Unito e l’Iran stanno procedendo spediti sul sentiero dell’automazione militare totale: da droni volanti come il Reaper americano e l’Harop israliano (un Ucav kamikaze), a sistemi di difesa automatici quali il sistema navale Aegis e quello aereo Patriot; da robot capaci di “pensare a se stessi”, a progetti futuristici come Hydra, una grande rete di piattaforme mobili sottomarine che dovrebbero ospitare sia Uav che Uuv (copyright del Pentagono).

«Molti Stati stanno lavorando su sistemi d’arma autonomi. – dice Casey-Maslen – Tutto è iniziato con la difesa missilistica, ma poi si è passati rapidamente alle macchine da guerra in senso più ampio. In effetti, la mia più grande paura è che i droni e i Faws siano utilizzati prima nella lotta al terrorismo (concetto abbastanza sfumato), poi in operazioni antidroga, infine per soffocare proteste pacifiche. Alcuni temono il loro uso sui campi di battaglia, ma penso che dovremmo aver più paura di un loro utilizzo lontano dai teatri di guerra». Stuart Casey-Maslen non è l’unico esperto a pensarla così. Uno dei più autorevoli attivisti anti-Faws, Noel Sharkey, docente emerito di intelligenza artificiale e robotica all’università di Sheffield, ha un’opinione simile. «Temo che robot sviluppati per scopi militari verranno utilizzati tra i civili per controllare le frontiere, svolgere operazioni di polizia e stroncare proteste pacifiche e scioperi. Si stanno già sviluppando robot con pistole taser per dare scosse elettriche alle persone, e anche robot che spruzzano spray al pepe nell’aria. Sistemi di sorveglianza autonomi eroderebbero la nostra sfera della privacy (già in via di rimpicciolimento) in modi che non possiamo nemmeno immaginare. Non è questo il futuro che io voglio per i miei nipoti. Non sappiamo come i governi del futuro, persino le democrazie avanzate, potrebbero usare un simile potere. Si potrebbe arrivare a forme striscianti di autoritarismo».